在数字化时代的浪潮中,数据被誉为新的石油,而算力则是开采这一资源的工具。随着技术的飞速发展,人类积累的数据量呈指数级增长,而与之相应的算力也在不断提升。然而,中国科学院计算技术研究所的王斌教授提出了一个引人深思的观点:人类已知的数据可能在几年之内被超大算力算尽。这一观点不仅揭示了当前数据处理能力的极限,也暗示了模型创新在未来的重要性。

自计算机诞生以来,人类就一直在追求更高的计算速度和更大的数据处理能力。从最初的电子管到现在的量子计算,算力的提升一直是技术进步的标志。然而,随着摩尔定律的逐渐失效,硬件性能的提升速度开始放缓,而数据量的增长却并未减速。这就导致了算力与数据量之间的差距逐渐缩小,甚至出现了算力即将触及数据处理极限的迹象。

王斌教授的预测正是基于这一背景。他认为,随着超大算力的不断发展,人类现有的数据集可能会在不久的将来被完全分析和处理。这意味着,单纯依靠增加算力来处理更多数据的方法将不再有效,我们需要寻找新的突破口。

在数据处理能力接近极限的情况下,模型创新成为了关键。传统的数据处理模型往往依赖于大量的数据输入和强大的算力支持,但在数据量有限的情况下,这些模型将难以发挥作用。因此,开发更加高效、智能的数据处理模型成为了当务之急。

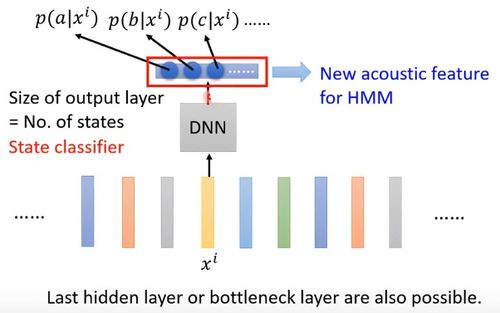

模型创新可以从多个方面入手。可以通过改进算法来提高数据处理的效率。例如,采用深度学习、强化学习等先进的机器学习技术,可以在较少的数据输入下实现更精准的预测和决策。其次,可以探索新的数据表示和处理方法,如使用图神经网络处理复杂的关系数据,或者利用生成对抗网络(GAN)生成新的数据样本。

跨学科的融合也是模型创新的重要途径。将物理学、生物学等领域的原理和方法引入数据处理中,可能会产生意想不到的效果。例如,借鉴生物神经网络的结构和功能,设计出更加高效的人工神经网络模型。

面对数据处理能力的极限,模型创新不仅是技术发展的需要,也是社会进步的必然要求。随着人工智能、大数据等技术的深入应用,模型创新将帮助我们更好地理解和利用数据,推动各行各业的发展。

王斌教授的观点提醒我们,在追求算力提升的不应忽视模型创新的重要性。只有不断探索和创新,我们才能在数据处理的道路上走得更远,实现从数据大国向数据强国的转变。

在未来,我们期待看到更多的模型创新成果,它们将引领我们进入一个更加智能、高效的数据处理新时代。而这一切,都始于对现有数据处理能力极限的认识,以及对模型创新不懈的追求。

2024澳门六合彩今晚开奖结果,最新成语解释落实_网页版47.66...

澳门今晚开奖结果揭晓:最新成语解释“落实_3DM46.46.54”...

2024新奥开奖记录39期:真实性答案曝光落实_V版26.29.5...

2024年香港正版资料费大全,最新成语解释落实_VIP16.28....

2024新澳门资料大全:真实性答案曝光落实_app4.72.50...